De la

mécanique au

numérique

Exposition virtuelle présentée par

Ellisa Ee, Gérald Leban, Kylian Pawilowski et Clément

Voisin

© 2024 Team 20

Partie 1 :

Les machines électromécaniques, avant l'informatique

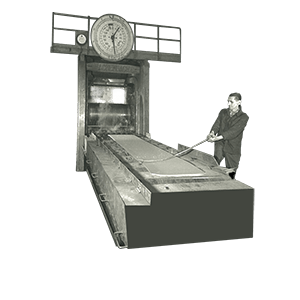

Après la Première Guerre mondiale, l'importation de machines statistiques américaines en Europe marque le début de la mécanographie, principalement utilisée dans les domaines de l'assurance, des statistiques et de l'actuariat. La société qui produisait les machines HOLLERITH, devenue IBM aux États-Unis, était représentée par la Compagnie Electro-Mécanique, qui est devenue IBM France en 1947.

À l'approche de la Seconde Guerre mondiale, les installations connaissaient une forte croissance, de l'ordre de 30 à 50 % annuels. Pendant la guerre, l'utilisation de circuits imprimés et de diodes au germanium a été introduite. L'après-guerre marque le début du succès de la mécanographie avec de nouvelles inventions comme les calculatrices et les premières mémoires de masse magnétiques, qui, en raison de leur capacité de programmation illimitée, deviennent centrales dans les systèmes de traitement de l'information.

En 1959, IBM présente une nouvelle génération d'ordinateurs, l'IBM 1401, qui intègre diverses fonctionnalités de différentes machines électromécaniques, telles que les tabulatrices, trieuses et interclasseuses. Le terme informatique est proposé en France en 1962, remplaçant progressivement la mécanographie dans les années 1960.

Partie 2 :

L'ordinateur devient grand public

Les ordinateurs personnels grand public sont apparus à la fin des années 1970 lorsque le coût et les dimensions des ordinateurs ont suffisamment diminué pour les rendre abordables. Voici les premiers ordinateurs personnels populaires.

Nous avons observé une multiplication des micro-ordinateurs dans les années 1980. Par exemple, IBM a produit l'IBM PC en 1981, qui était beaucoup plus cher que le prix du marché à cette époque et nécessitait son propre écran, alors que les micro-ordinateurs typiques pouvaient utiliser l'écran de télévision. La carte graphique CGA, sortie en 1981, était coûteuse et limitée à 4 couleurs. Trois ans plus tard, en 1984, IBM a lancé l'Enhanced Graphics Adapter, qui supportait 16 couleurs.

Ces machines sont venues accompagnées de systèmes d'exploitation, des interfaces textuelles

rudimentaires de

DOS

dans les années 1980, jusqu'aux environnements graphiques intuitifs de Windows 95 ou encore Mac

OS 7. Cette période a été marquée par une course à la performance et à la raffinement, avec l'apparition

de systèmes comme

FreeBSD

et GNU/Linux, venus contester l'hégémonie de Microsoft.

Windows dominait alors le marché des ordinateurs personnels, Mac OS s'était imposé comme le choix

privilégié des créatifs, tandis que les systèmes Unix, ancêtres de FreeBSD et GNU/Linux, régnaient

sur les serveurs et les environnements professionnels. Cette diversification s'est accompagnée

d'une explosion des usages, avec l'arrivée d'Internet et l'essor des navigateurs web comme Netscape

et Internet Explorer, qui ont bouleversé le paysage numérique et posé les bases de notre ère connectée.

Info : Images de Windows 95 et Système 1 d'Apple vers la fin de cette galerie.

Partie 3 :

Le phénomène Internet

Le développement d'Internet commence avec la création de la DARPA en 1958 et le lancement d'ARPANET en 1969. Des innovations clés incluent le protocole TCP/IP par Vint Cerf et Bob Kahn dans les années 1970, et l'invention de l'e-mail par Ray Tomlinson en 1971. Le World Wide Web, créé par Tim Berners-Lee du CERN en 1989, révolutionne le partage de l'information, rendant Internet accessible au grand public dans les années 1990 grâce aux protocoles HTTP et HTML.

L'expansion du web dans les années 1990 et 2000 marque une nouvelle ère pour Internet. Google, fondé en 1998, devient rapidement le moteur de recherche dominant grâce à son algorithme innovant de classement des pages. Amazon, créé par Jeff Bezos en 1994, révolutionne le commerce en ligne avec son modèle de vente de livres puis d'une vaste gamme de produits.

Le Web 2.0 marque une évolution de l'Internet, où les utilisateurs peuvent non seulement consulter du contenu, mais aussi en créer et le partager facilement. Par exemple, des plateformes comme Facebook et YouTube permettent à chacun de publier des photos, des vidéos et des commentaires, transformant le web en un espace interactif, collaboratif et communautaire.

Les géants de l'informatique ne sont désormais plus seulement IBM, Microsoft ou Apple, mais aussi ces nouveaux joueurs du web comme Google, Amazon ou encore Facebook. Les anciens leaders du marché ont dû s'adapter : Apple offre désormais plusieurs services comme iCloud et Apple Music, tandis que Microsoft concentre ses efforts vers ses services professionnels avec Microsoft 365 et Azure. Cette transition a permis à ces entreprises de rester compétitives alors que le web a créé un paysage technologique en constante évolution.

Partie 4 :

Des nouvelles technologies au service de l'humanité ?

Le milieu des années 2010 a été marquée par une évolution fulgurante des gadgets connectés et de la réalité virtuelle. Les objets connectés ont envahi nos foyers, devenant des assistants intelligents pour nos besoins quotidiens. La réalité virtuelle, quant à elle, a fait ses premiers pas dans le grand public, promettant une immersion totale dans des mondes virtuels. Des appareils comme l'Oculus Rift de Facebook/Meta ou l'Apple Vision Pro ont ouvert la voie à une communication plus intuitive et immersive, laissant entrevoir un futur où la réalité virtuelle pourrait devenir le mode d'interaction dominant.

L'intelligence artificielle (IA) a connu un essor considérable durant cette période. D'abord cantonnée à des utilisations contrôlées et fermées, comme les algorithmes de recommandation et les suggestions prédictives, l'IA a évolué vers des applications plus sophistiquées. L'IA générative a notamment permis l'émergence de nouvelles formes d'expression artistique et de création de contenu.

Néanmoins, cette évolution rapide n'est pas sans risque. L'absence de régulation adéquate soulève des inquiétudes quant aux impacts environnementaux et sociaux de l'IA, notamment en ce qui concerne la consommation énergétique des IA génératives et la collecte massive de données sans consentement. La question de l'éthique et de la responsabilité dans le développement et l'utilisation de l'IA devient de plus en plus cruciale.

La technologie a connu une transformation profonde entre 2015 et 2020, et son évolution ne cesse de s'accélérer. La réalité virtuelle, l'intelligence artificielle et d'autres innovations promettent de révolutionner notre façon de vivre, de travailler et de communiquer. Cependant, il est essentiel de rester vigilant quant aux risques potentiels de ces technologies et de mettre en place des garde-fous pour garantir un développement responsable et éthique de l'IA et des autres innovations technologiques.

Fin

Merci d'avoir lu jusqu'au bout !

Crédits

Réalisé dans le cadre de première année de BUT Informatique.

Les images, icônes et autres éléments graphiques sont la propriété de leurs auteurs respectifs.

Équipe

- Chef de projet : Clément VOISIN

- Réalisation du site web : Clément VOISIN, Gérald LEBAN, Kylian PAWILOWSKI

- Éléments graphiques : Clément VOISIN

- Écriture : Ellisa EE, Clément VOISIN, Gérald LEBAN, Kylian PAWILOWSKI

- Recherche : Clément VOISIN, Ellisa EE